Microsoft は、主力製品である Surface Laptop Studio PC のプロセッサに関して NVIDIA と提携していますが、同社はAMD アクセラレータ Instinct M1300X チップを使用することを選択しています。データセンター。

AMD の Advancing AI イベント中に、同社は壇上に上がり、AI に焦点を当てた GPU と需要を巡る最近の NVIDIA 主導のプロセッサー競争の流入に対抗する計画に関する一連のニュースを発表しました。

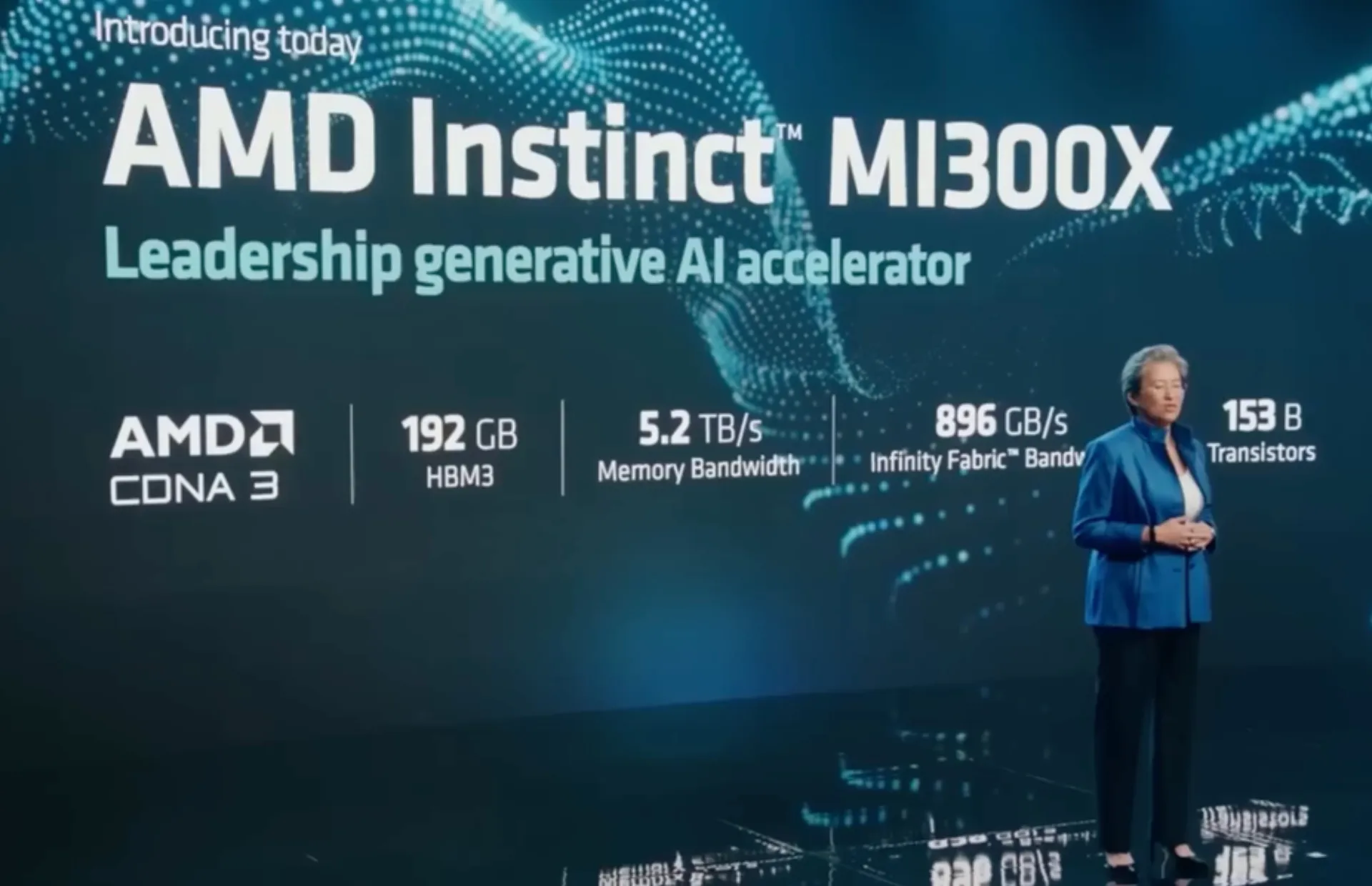

ステージ上で、AMD CEO の Lisa Su 氏は、Instinct MI300X GPU とハイブリッド CPU-GPU MI300A APU を発表しました。これは、NVIDIA 自身の競合する GPU パフォーマンスよりも 1.6 倍リードしていると同社は主張しています。

部分的には、AMD は、CDNA 3 グラフィックス エンジンとメッシュされた 24 個の Zen 4 CPU コアと 8 つの高解像度スタックを組み込んだ 3D スタックに組み込まれた 13 個のチップレットを含む設計を含む新しい MI300 アーキテクチャで、主張する優位性を達成することができました。 – 全体のサイズが 1,460 億個のトランジスタを持つ帯域幅メモリ (HBM3)。

Instinct M1300X には 192GB の HBM3 が搭載されており、これは NVIDIA の H100 SXM GPU 80GB HMB3 の上限の 2 倍の上限に相当します。 AMD の Instinct M1300 は、その栄誉に甘んじることなく、より高い 141GB の HBM3e を搭載するようにも構築されており、NVIDIA が新たに発表した H200 チップよりも優れた性能を発揮するはずです。

M1300X は、AMD がこれまでに製造したチップの中で最大のものです。

M1300A は、パフォーマンスのラダーを 1 段階下げて、同社の EPYC チップと同じ 86 ベースの Zen 4 コア アーキテクチャをコピーし、128 GB の HBM3 メモリを備えた GPU と CPU コアを組み合わせてホストし、従来よりも最大 60% 高い容量を生成します。 NVIDIAのH100 GPUも同様です。

現在の業界リーダーである NVIDIA の H100 と比較したパフォーマンスの向上に関して、AMD は、同社の M1300 AI チップが 122.6 テラフロップスの FP64 マトリックス演算に達し、H100 よりもほぼ 80% 上回ると主張しています。

AMDはすでにDellから新しいGPUを受注しており、HP、Lenovo、Supermicroなどの他の企業も市場での競争を利用しようとしている。

Microsoft は独自の OpenAI と提携した AI サーバー チップの開発に取り組んでいますが、同社は AMD の新リリースを支援する最大手のクラウド サービス プロバイダーの 1 つでした。 M1300X を使用して、Azure 上で実行される仮想マシンを強化する予定です。

コメントを残す ▼