Während Microsoft mit NVIDIA für Prozessoren in seinen Flaggschiff-PCs Surface Laptop Studio zusammenarbeitet, entscheidet sich das Unternehmen für die Verwendung der AMD-Beschleuniger Instinct M1300X seine Rechenzentren.

Während des Advancing AI-Events von AMD betrat das Unternehmen die Bühne, um eine Reihe von Neuigkeiten über seinen Plan bekannt zu geben, den jüngsten Zustrom der von NVIDIA angeführten Prozessorkonkurrenz rund um KI-fokussierte GPUs und deren Nachfrage zu bekämpfen.

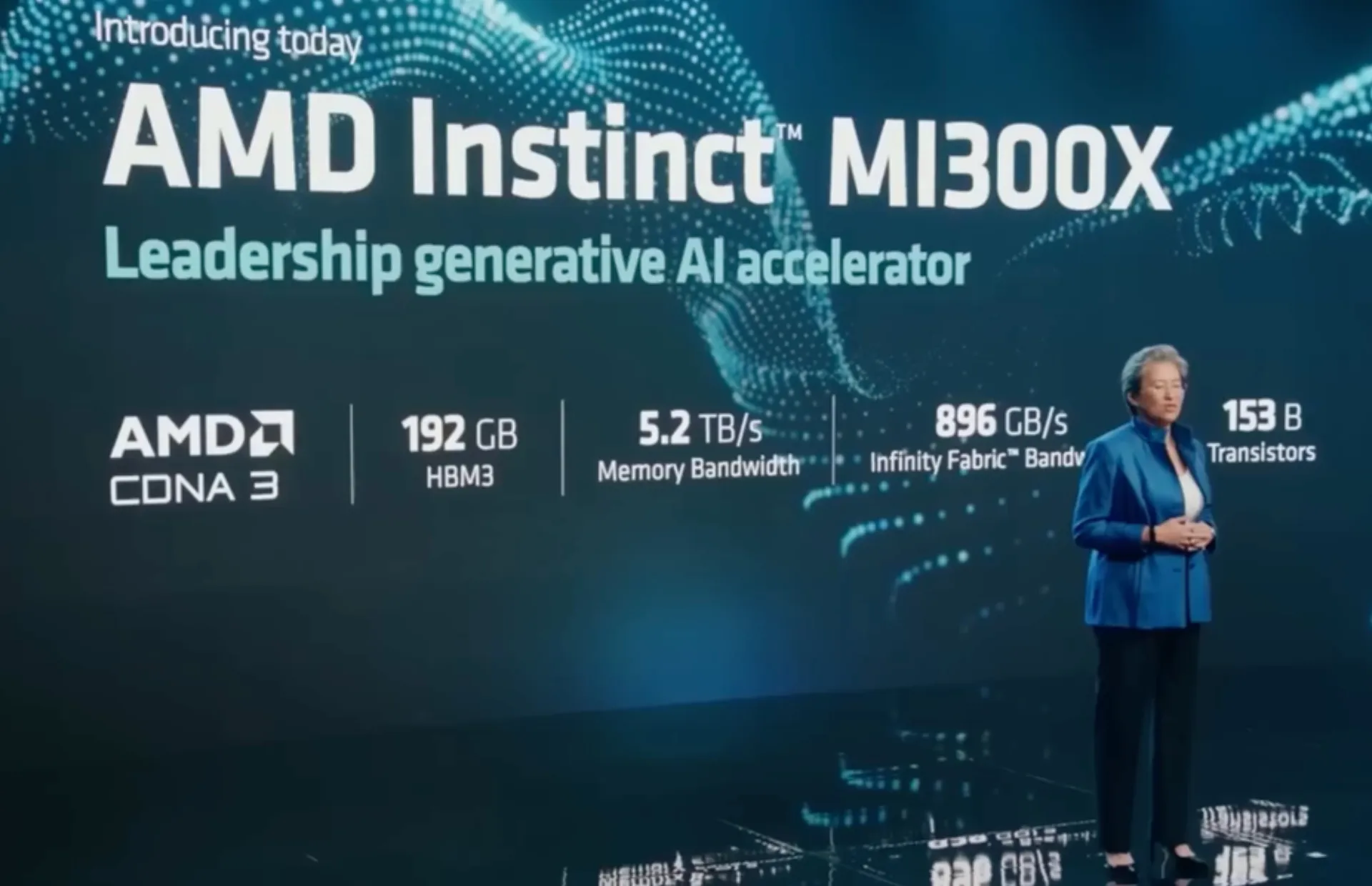

Auf der Bühne stellte AMD-CEO Lisa Su die Instinct MI300X-GPU und die Hybrid-CPU-GPU MI300A-APU vor, die nach Angaben des Unternehmens einen 1,6-fachen Vorsprung vor NVIDIAs eigener Konkurrenz-GPU-Leistung haben.

Teilweise konnte AMD seine behauptete Vormachtstellung mit seiner neuen MI300-Architektur erreichen, die ein Design umfasst, das 13 Chiplets in einem 3D-Stack umfasst, der vierundzwanzig Zen 4-CPU-Kerne, die mit der CDNA 3-Grafik-Engine vernetzt sind, und acht High-Stacks umfasst -Bandbreitenspeicher (HBM3) mit einer Gesamtgröße von 146 Milliarden Transistoren.

Der Instinct M1300X ist mit 192 GB HBM3 ausgestattet, was einer doppelt so hohen Grenze entspricht als die 80 GB HMB3-Grenze der H100 SXM GPU von NVIDIA. AMDs Instinct M1300 gibt sich nicht damit zufrieden, sich auf seinen Lorbeeren auszuruhen, sondern wurde auch für die Unterbringung von 141 GB größerem HBM3e entwickelt, was auch den neu angekündigten H200-Chip von NVIDIA übertreffen dürfte.

Der M1300X ist der größte Chip, den AMD bisher produziert hat.

Der M1300A geht auf der Leistungsleiter eine Stufe tiefer und kopiert die gleiche 86-basierte Zen-4-Kernarchitektur wie die EPYC-Chips des Unternehmens, die einen kombinierten GPU- und CPU-Kern mit 128 GB HBM3-Speicher beherbergen und eine bis zu 60 % höhere Kapazität bieten sollen Auch die H100-GPU von NVIDIA.

Was die Leistungssteigerungen gegenüber dem H100 des aktuellen Branchenführers NVIDIA angeht, gibt AMD an, dass sein M1300 AI-Chip 122,6 Teraflops bei FP64-Matrixoperationen erreichen kann, womit er dem H100 um fast 80 % voraus wäre.

AMD hat bereits Bestellungen für seine neuen GPUs von Dell entgegengenommen, während andere Unternehmen wie HP, Lenovo und Supermicro versuchen, von der Konkurrenz auf dem Markt zu profitieren.

Während Microsoft an seinen eigenen OpenAI-Partner-KI-Serverchips arbeitet, gehörte das Unternehmen zu den größten Cloud-Dienstanbietern, die die neue Version von AMD unterstützten Es ist geplant, den M1300X zur Stromversorgung virtueller Maschinen zu verwenden, die auf Azure ausgeführt werden.

Schreibe einen Kommentar