Mentre Microsoft collabora con NVIDIA per i processori dei suoi PC Surface Laptop Studio di punta, l’azienda sceglie di utilizzare i chip dell’acceleratore AMD Instinct M1300X in i suoi data center.

Durante l’evento Advancing AI di AMD, la società è salita sul palco per diffondere una serie di notizie riguardanti il suo piano per combattere il recente afflusso di concorrenza di processori guidata da NVIDIA riguardo alle GPU e alla domanda focalizzate sull’intelligenza artificiale.

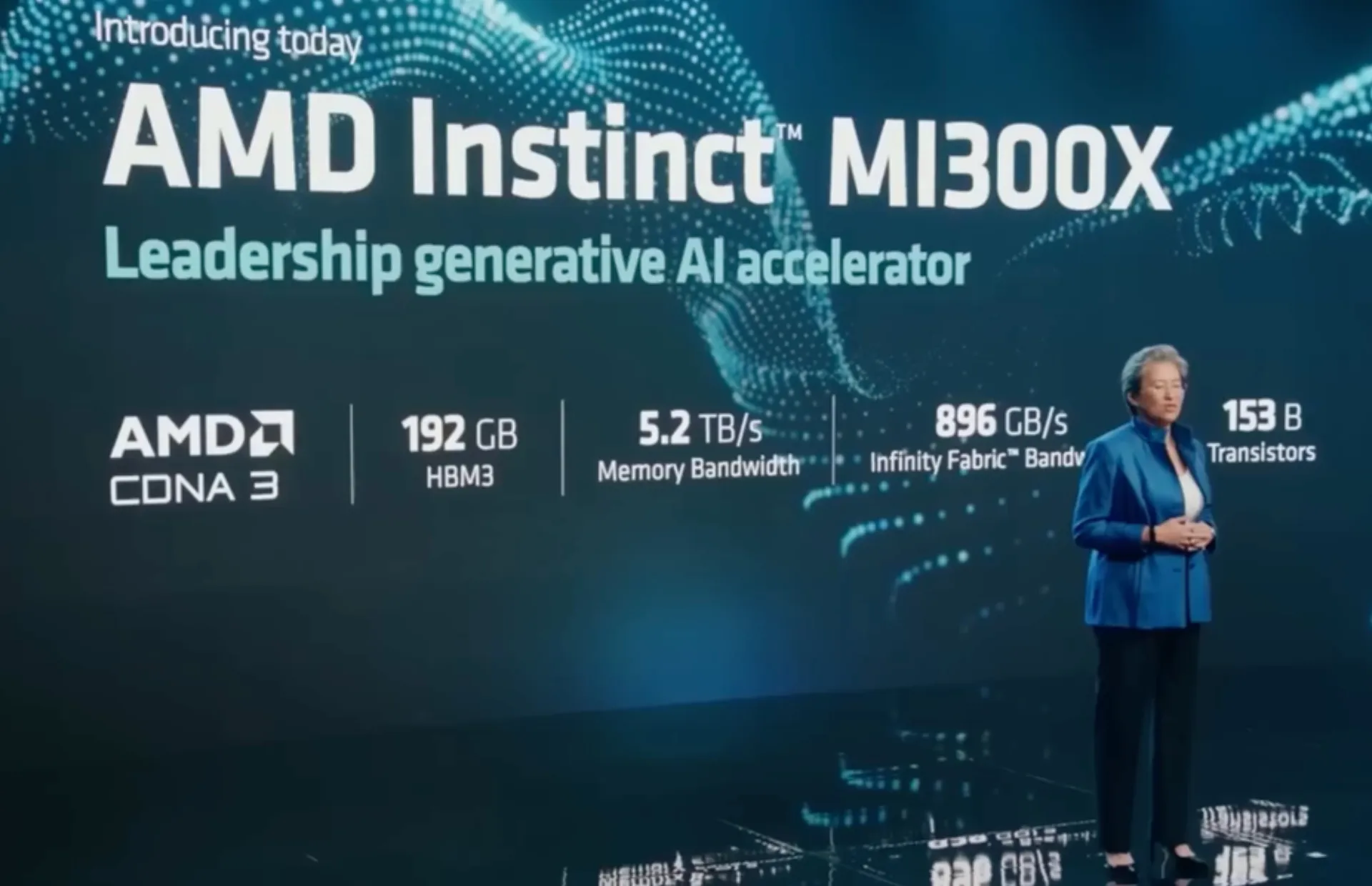

Sul palco, il CEO di AMD Lisa Su ha presentato la GPU Instinct MI300X e l’APU ibrida CPU-GPU MI300A che, secondo la società, hanno un vantaggio di 1,6 volte rispetto alle prestazioni delle GPU concorrenti di NVIDIA.

In parte, AMD è riuscita a raggiungere la sua pretesa supremazia con la sua nuova architettura MI300 che include un design che coinvolge 13 chiplet costruiti in uno stack 3D che incorpora ventiquattro core CPU Zen 4 abbinati al motore grafico CDNA 3 e otto stack di alta qualità. -memoria a larghezza di banda (HBM3) con una dimensione complessiva di 146 miliardi di transistor.

L’Instinct M1300X viene fornito con 192 GB di HBM3 che equivale a un limite 2 volte superiore rispetto al limite HMB3 da 80 GB della GPU H100 SXM di NVIDIA. Non soddisfatto di riposare sugli allori, l’Instinct M1300 di AMD è stato costruito anche per ospitare ben 141 GB di HBM3e che dovrebbe anche sovraperformare il chip H200 appena annunciato da NVIDIA.

L’M1300X è il chip più grande prodotto da AMD fino ad oggi.

Scendendo di un livello nella scala delle prestazioni, l’M1300A copia la stessa architettura core Zen 4 basata su 86 dei chip EPYC dell’azienda che ospitano una GPU combinata e un core CPU con 128 GB di memoria HBM3 e dovrebbe produrre fino al 60% di capacità in più rispetto a Anche la GPU H100 di NVIDIA.

Per quanto riguarda i miglioramenti in termini di prestazioni rispetto all’attuale leader del settore NVIDIA H100, AMD afferma che il suo chip AI M1300 può raggiungere 122,6 teraflop di operazioni su matrice FP64, il che lo porrebbe davanti all’H100 di quasi l’80%.

AMD ha già ricevuto ordini per le sue nuove GPU da Dell, mentre altre aziende come HP, Lenovo e Supermicro cercano di trarre vantaggio dalla concorrenza sul mercato.

Mentre Microsoft sta lavorando ai propri chip server AI partner di OpenAI, è stato tra i maggiori fornitori di servizi cloud a sostenere la nuova versione di AMD come prevede di utilizzare M1300X per alimentare macchine virtuali in esecuzione su Azure.

Lascia un commento