Alors que Microsoft s’associe à NVIDIA pour les processeurs de ses PC phares Surface Laptop Studio, la société choisit d’utiliser les puces de l’accélérateur AMD Instinct M1300X dans ses centres de données.

Lors de l’événement Advancing AI d’AMD, la société a pris la parole pour annoncer une multitude de nouvelles concernant son plan visant à lutter contre l’afflux récent de concurrence en matière de processeurs dirigée par NVIDIA autour des GPU axés sur l’IA et de la demande.

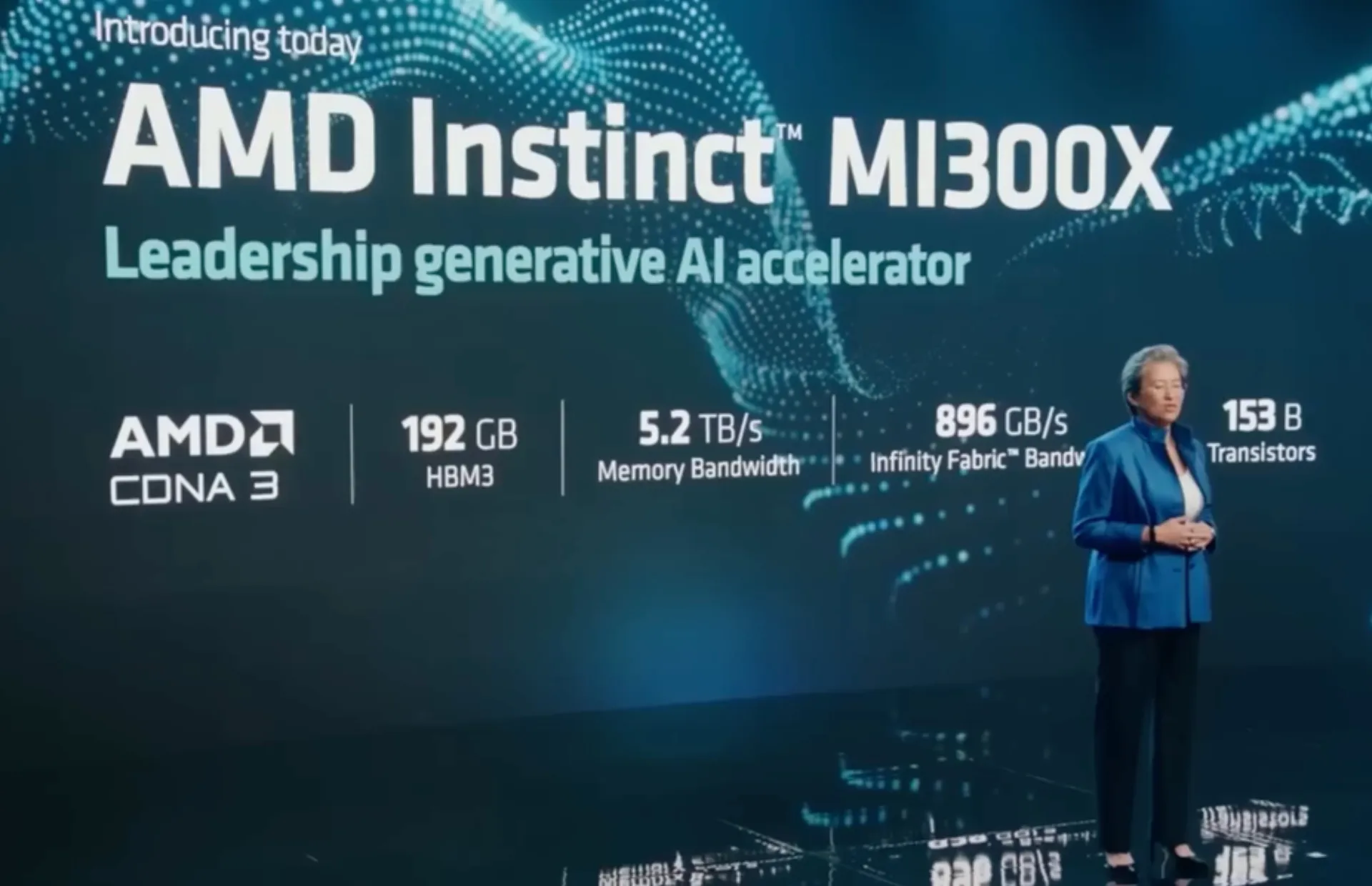

Sur scène, Lisa Su, PDG d’AMD, a dévoilé le GPU Instinct MI300X et l’APU hybride CPU-GPU MI300A qui, selon la société, ont une avance de 1,6 fois sur les performances GPU concurrentes de NVIDIA.

En partie, AMD a réussi à atteindre sa suprématie revendiquée grâce à sa nouvelle architecture MI300 qui comprend une conception impliquant 13 chipsets construits dans une pile 3D qui intègre vingt-quatre cœurs de processeur Zen 4 maillés avec le moteur graphique CDNA 3 et huit piles de haute performance. -mémoire à bande passante (HBM3) d’une taille globale de 146 milliards de transistors.

L’Instinct M1300X est livré avec 192 Go de HBM3, ce qui équivaut à une limite 2 fois plus élevée que le plafond HMB3 de 80 Go du GPU H100 SXM de NVIDIA. Non content de se reposer sur ses lauriers, l’Instinct M1300 d’AMD a également été conçu pour héberger 141 Go de HBM3e, ce qui devrait également surpasser la puce H200 récemment annoncée par NVIDIA.

Le M1300X est la plus grande puce produite par AMD à ce jour.

En descendant d’un cran sur l’échelle des performances, le M1300A copie la même architecture de cœur Zen 4 basée sur 86 que les puces EPYC de l’entreprise qui hébergent un cœur de GPU et de CPU combinés avec 128 Go de mémoire HBM3 et devraient produire jusqu’à 60 % de capacité en plus par rapport à Le GPU H100 de NVIDIA également.

En ce qui concerne les gains de performances par rapport au H100 de NVIDIA, leader actuel du secteur, AMD affirme que sa puce M1300 AI peut atteindre 122,6 téraflops d’opérations matricielles FP64, ce qui la placerait de près de 80 % devant le H100.

AMD a déjà pris des commandes pour ses nouveaux GPU auprès de Dell, tandis que d’autres sociétés telles que HP, Lenovo et Supermicro cherchent à profiter de la concurrence sur le marché.

Alors que Microsoft travaille sur ses propres puces de serveur d’IA en partenariat avec OpenAI, il fait partie des plus grands fournisseurs de services cloud à soutenir la nouvelle version d’AMD. il prévoit d’utiliser le M1300X pour alimenter les machines virtuelles exécutées sur Azure.

Laisser un commentaire